En 1972, el psiquiatra Kenneth Colby creó un programa llamado Parry para simular el lenguaje de una persona con esquizofrenia paranoide con el objetivo de capacitar a estudiantes en la atención a pacientes reales. El éxito de Parry fue tal que logró pasar la prueba de Turing, diseñada para evaluar la inteligencia de una máquina comparable a la de un ser humano. Actualmente, investigadores de la Universidad de Oxford exploran el uso de inteligencia artificial para predecir problemas de salud mental en el futuro, a través de conversaciones con jóvenes.

El potencial del fenotipado digital es una técnica que se está utilizando para recolectar y analizar datos de dispositivos móviles, como la actividad física o la ubicación, utilizando inteligencia artificial con el objetivo de predecir problemas de salud mental. Sin embargo, este enfoque plantea interrogantes sobre el consentimiento y la privacidad, especialmente en el caso de menores de edad. Empresas como Facebook ya están utilizando IA para detectar publicaciones que indiquen riesgo de suicidio y enviarlas a moderadores humanos para su revisión.

El estudio de la Organización Mundial de la Salud encontró deficiencias en la forma en que se está utilizando la inteligencia artificial en la investigación de la salud mental, principalmente enfocada en trastornos depresivos, esquizofrenia y otros trastornos psicóticos. Se detectaron problemas de manejo de datos, validación de datos y riesgo de sesgo, lo cual podría afectar la precisión de los diagnósticos en ciertos grupos étnicos con menos acceso a la atención médica. Esto plantea la necesidad de una colaboración estrecha entre expertos en IA y profesionales de la salud mental.

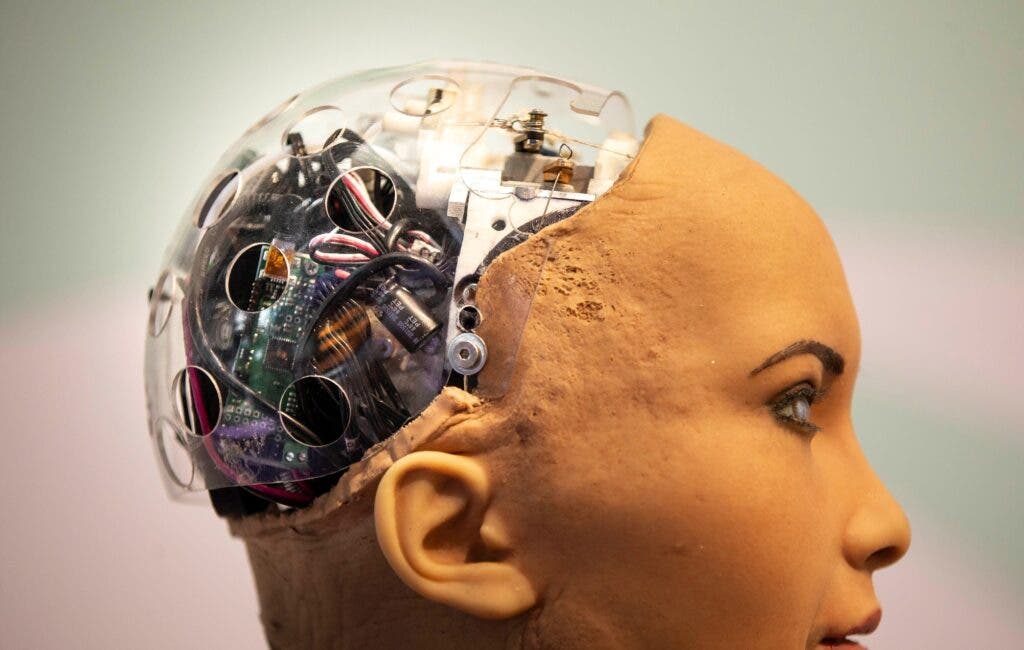

En el Mobile World Congress, se presentó una recreación de ‘La Creación de Adán’ de Miguel Ángel en la que un humano le da vida a un robot, resaltando la conexión entre la humanidad y la inteligencia artificial. El uso de IA en salud mental plantea desafíos éticos, como el derecho a la privacidad y el consentimiento, especialmente en el caso de menores de edad. En Estados Unidos, Facebook implementó un programa para detectar publicaciones que puedan indicar riesgo de suicidio y enviarlas a moderadores humanos para su revisión.

La falta de transparencia y fallos metodológicos en la investigación de IA en salud mental son preocupantes, ya que retrasan la aplicación segura de esta tecnología. Es importante garantizar que las tecnologías respeten la dignidad y autonomía de los pacientes para maximizar sus beneficios. La colaboración entre expertos en IA y profesionales de la salud mental es fundamental para superar los desafíos y garantizar la viabilidad de estas nuevas tecnologías en el mundo real.

Los investigadores de la Universidad de Oxford están utilizando inteligencia artificial para predecir problemas de salud mental en el futuro, mientras que empresas como Facebook ya implementan programas para detectar riesgos de suicidio en publicaciones. La ética y la privacidad son temas importantes a considerar en el uso de IA en la salud mental, y la colaboración entre expertos en IA y profesionales de la salud mental es crucial para garantizar la eficacia y seguridad de estas tecnologías.